Llama3 模型安装

前言

最近研究了一下大模型,想要本地运行一个试试,发现 Llama 是一个不错的选择。

LLaMA 是 Large Language Model Meta AI 的缩写,是由 Meta(原 Facebook)研发的一系列大规模语言模型。这些模型被设计用于自然语言处理任务,如文本生成、问题回答和语言理解等。LLaMA 系列模型的目标是为研究社区提供高性能的语言模型,同时降低训练和推理的资源需求。

Llama 相较于其他语言模型更轻量级,不过它并不是完全开源的,需要申请访问权限。

注意:

访问官网需要科学上网,并需要将自己的 IP 修改到美国、日本等区域。

安装 Llama

下载 Llama 需要提前配置好 Python 环境,这里不再赘述 Python 的安装过程。

申请下载

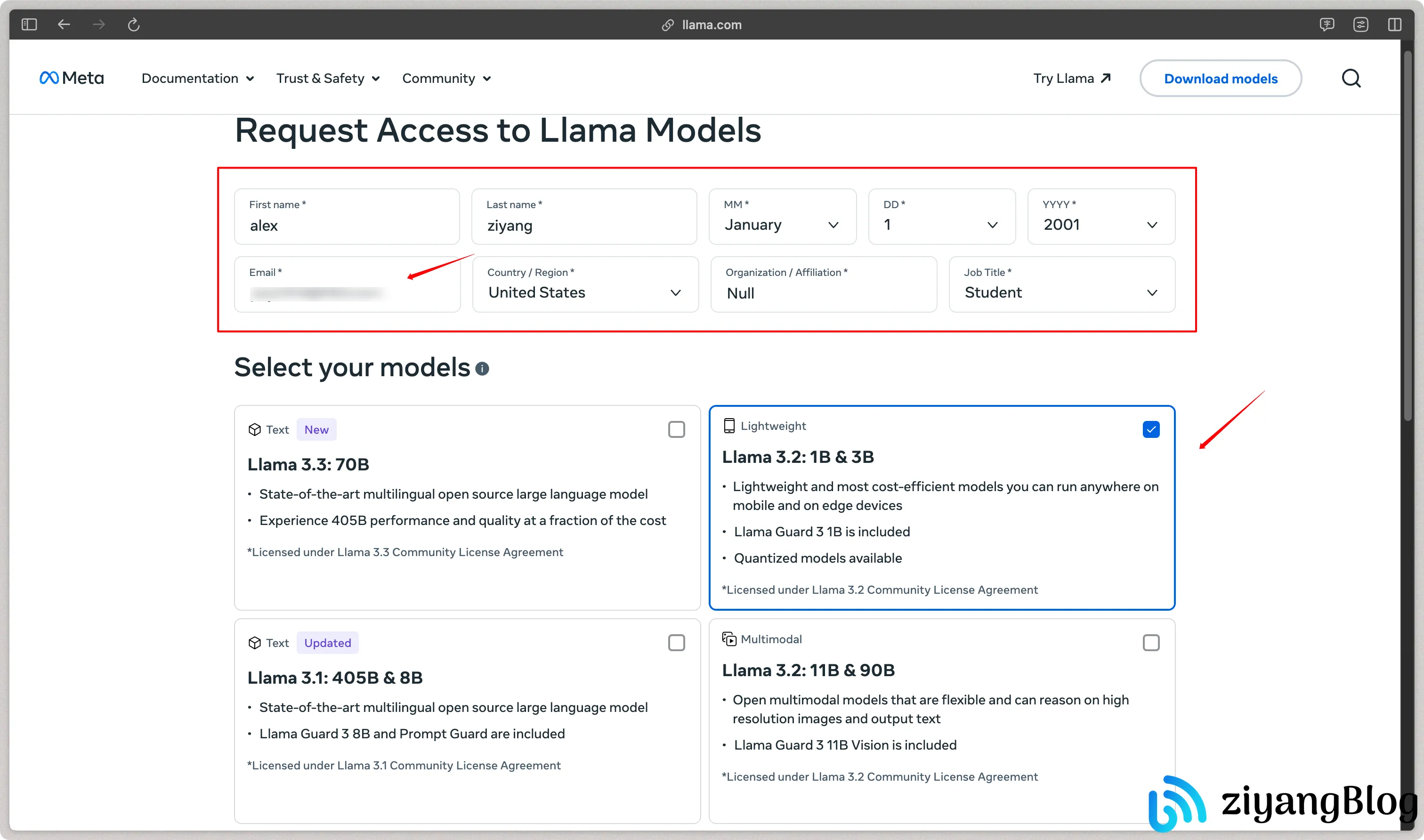

进入官网下载界面,填写相关信息。

Email一定要填写真实邮箱,因为后续需要接收授权码,其他信息可以随意填写。选择需要下载的模型,默认展示的是最新的版本。

如果需要下载旧版本(例如

Llama2),点击页面底部的Previous language & safety models。选择完成后,不需要勾选订阅,直接点击下一步。

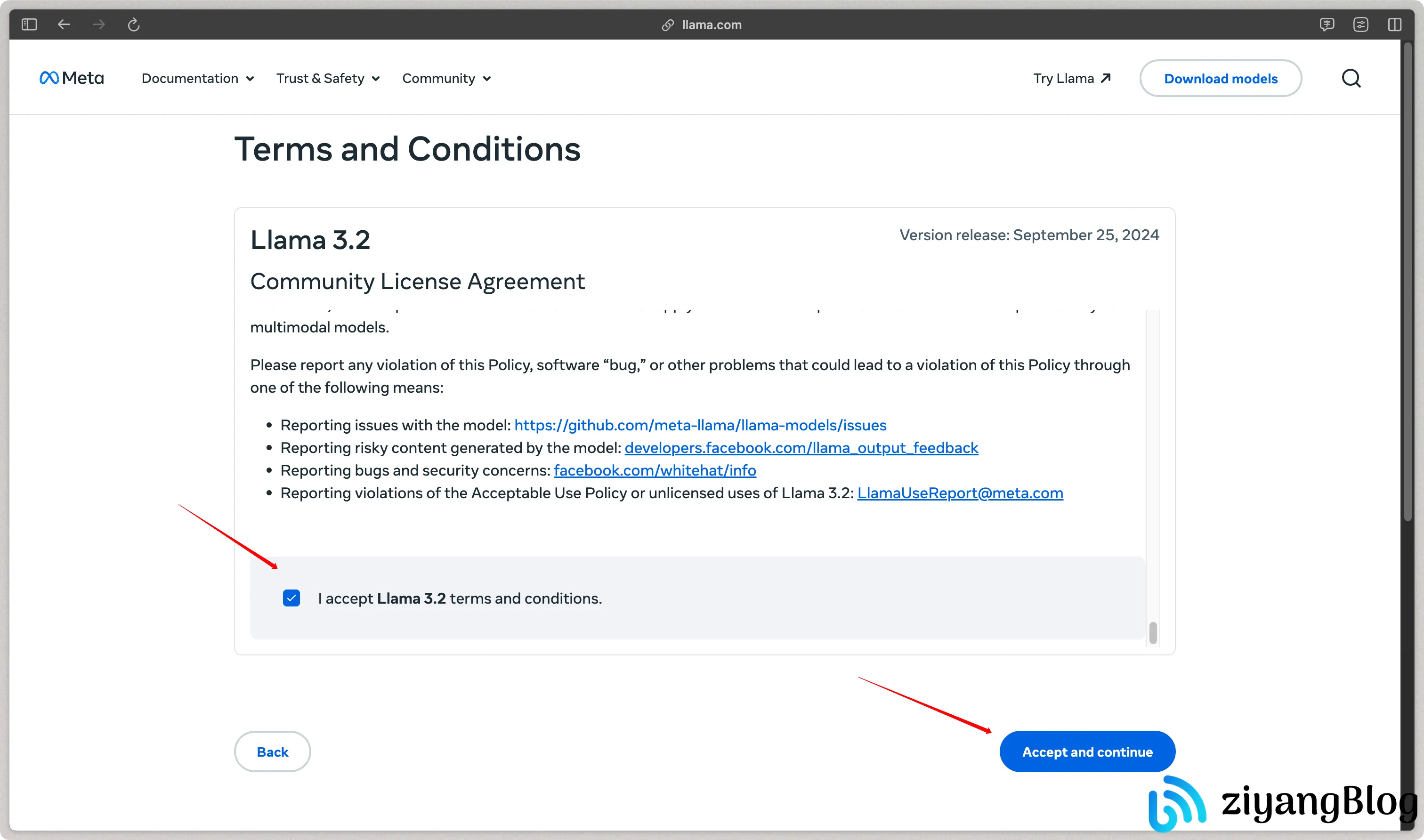

进入许可界面后,拉到页面底部,勾选

I accept Llama 3.2 terms and conditions.注意,在点击

Accept and continue按钮前,请确保已经挂载代理,否则点击后可能无响应。只有海外 IP 地址才能进入下一页。

点击下一步后,如果看到如下页面,则说明申请成功,此时你的邮箱会收到一封授权邮件。

接收邮件

正常情况下,你会收到一封或多封邮件,具体数量取决于申请的模型数量。每个邮件中包含一个单独的授权码。完整的授权链接如下图所示,下载时需要将这个链接拷贝使用。

注意:

收到邮件后应当尽快下载,授权链接仅在2 天内有效,且每个授权链接仅支持下载 5 次。

安装 Llama stack

打开终端,使用 pip 安装 llama-stack:

1 | |

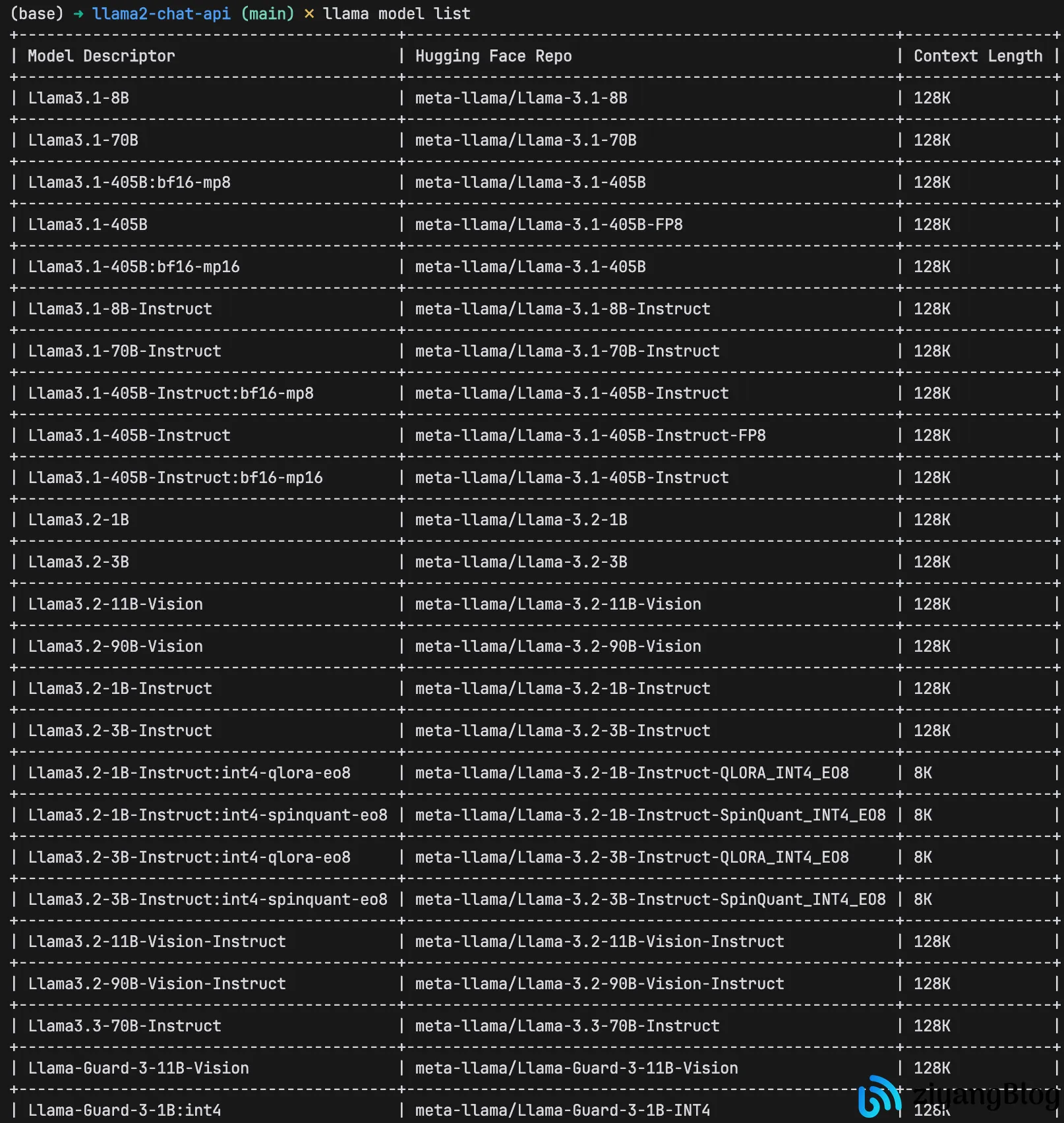

查看模型列表

安装完成后,可以使用 llama 命令查询当前的模型列表:

1 | |

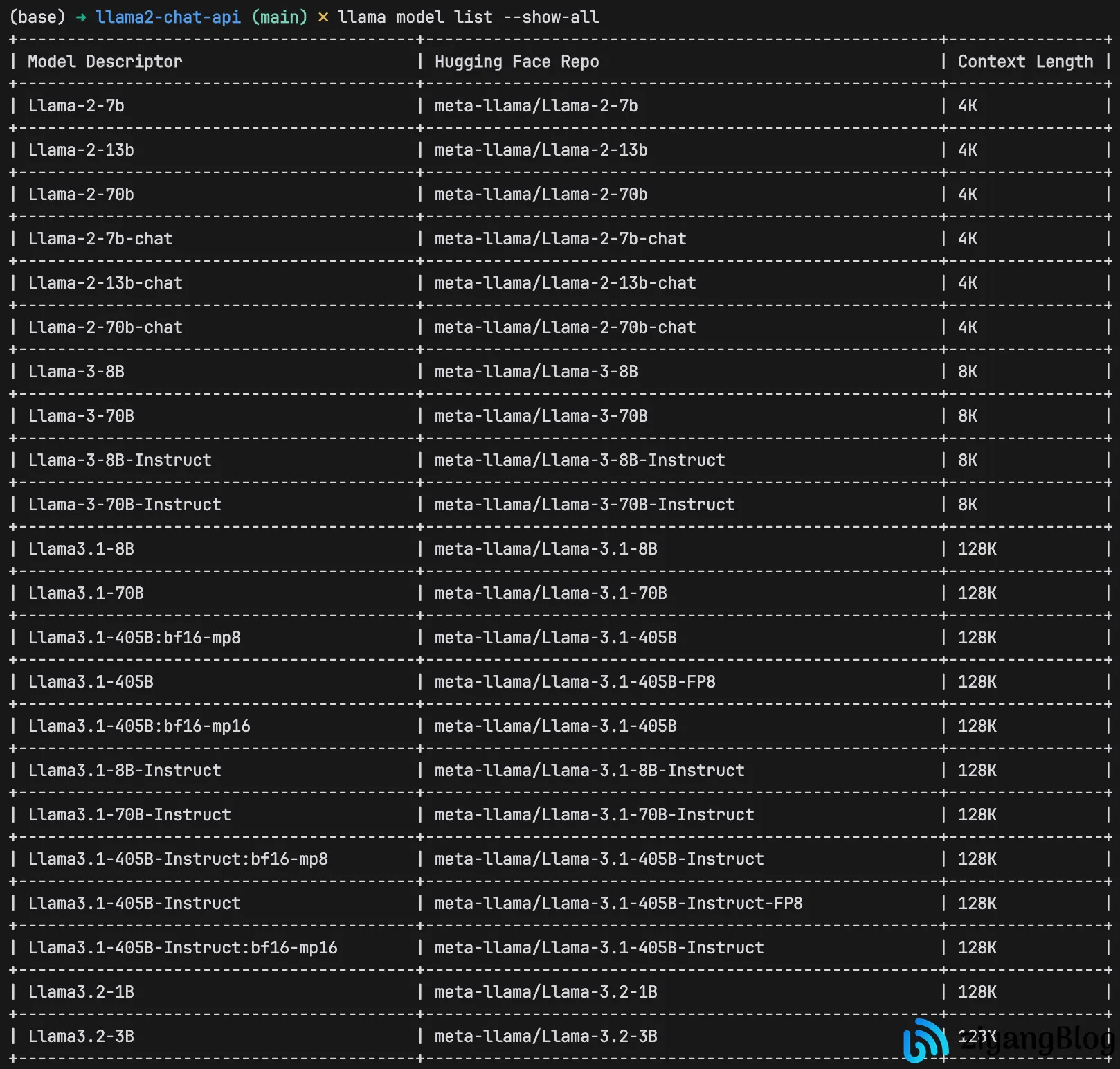

加入 --show-all 参数可以查看所有模型:

1 | |

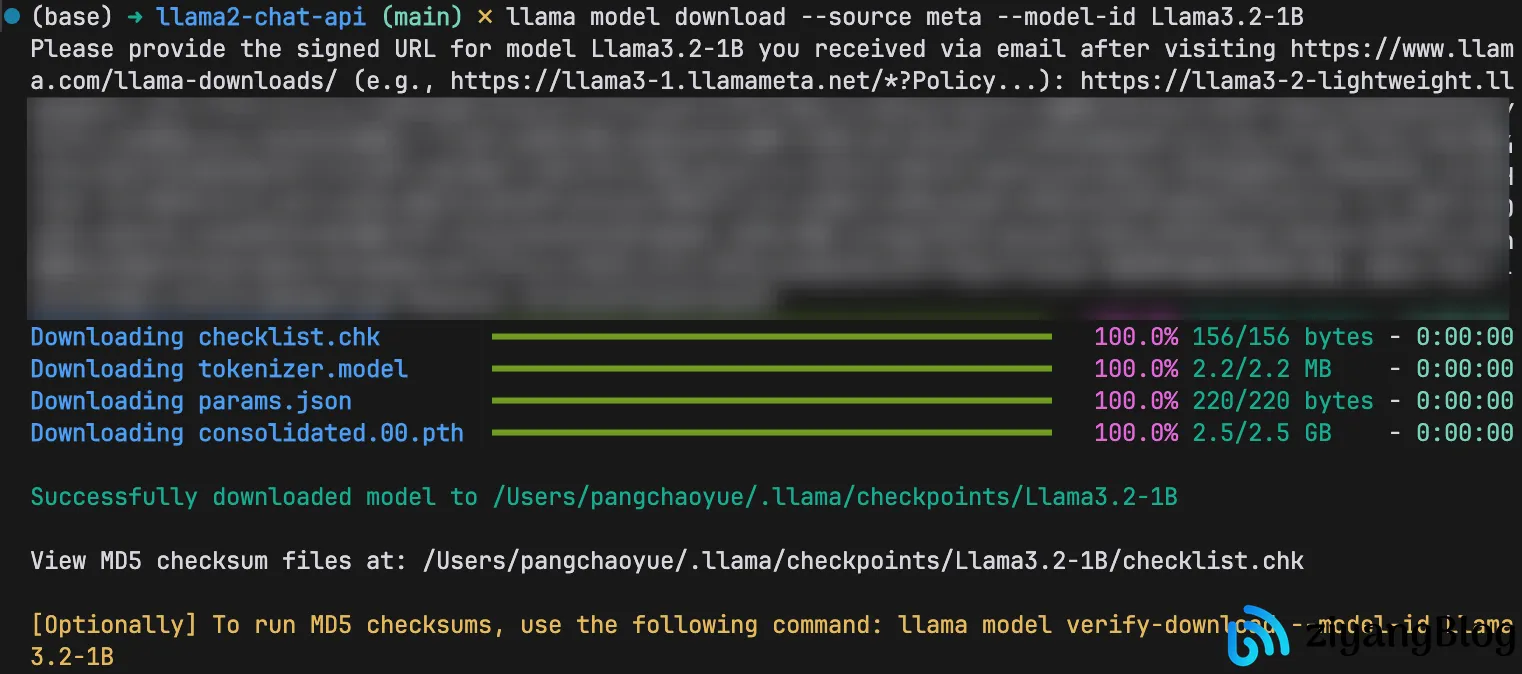

下载模型

使用以下命令下载模型,其中 <model_id> 是官网申请时指定的模型 ID。

1 | |

执行后,系统会提示:

1 | |

此时将邮件中的完整链接粘贴进去即可开始下载。

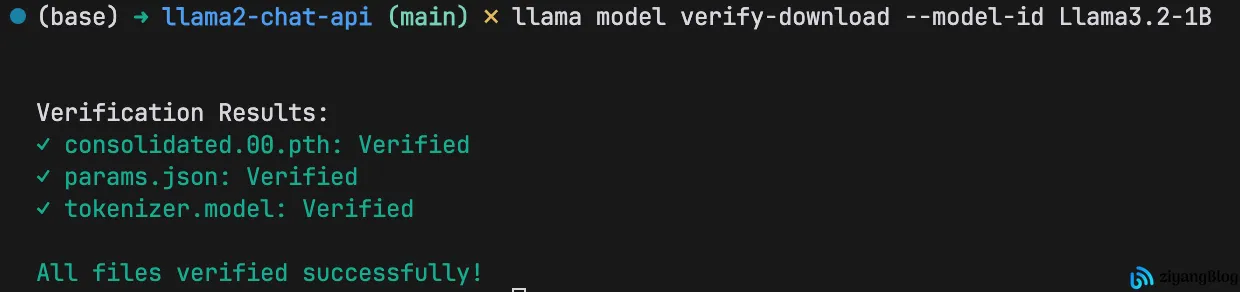

校验包完整性

下载完成后,使用以下命令校验包的完整性:

1 | |

如果提示 All files verified successfully!,则说明文件完整无误。

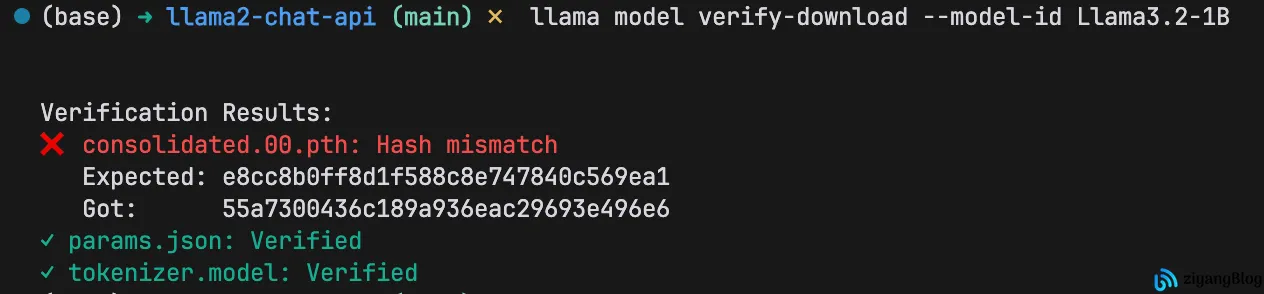

如果某个文件提示 Hash mismatch,说明下载的文件不完整,需要删除后重新下载。

运行示例

运行示例需要英伟达显卡支持,否则会报错。

下载 llama-models

1 | |

安装依赖

运行示例前需要安装依赖:

1 | |

运行示例脚本

安装依赖后,可以运行 llama-models 提供的示例脚本。示例脚本位于 llama_models/models/scripts/ 目录下。

以下是一个示例运行脚本:

1 | |

结语

由于我用的是 Mac 且没有配备显卡,因此未能成功运行官方示例程序。不过,通过以上步骤,已经可以成功完成 Llama 模型的安装与下载。下一篇文章,我将详细讲解如何通过 HuggingFace 平台快速部署并运行 Llama 模型。

相关链接

- Llama 官网: https://www.llama.com

- LLaMA Models GitHub: https://github.com/meta-llama/llama-models